Ayer abrí un proyecto frontend en Replit que tenía olvidado desde hace semanas. De esos que uno empieza de golpe, con una idea rápida, sin estructura ni un plan claro, solo con las ganas de no dejar pasar un momento creativo. Lo dejé a medio camino, como muchos proyectos que compiten con las urgencias del día a día.

Era un caos total, más de lo que recordaba: componentes mezclados, funciones mal nombradas, carpetas sin lógica aparente, como suele pasar cuando uno empieza a hacer grandes cambios con un agente sobre un proyecto ya existente. Y más allá de los agentes, una escena común para cualquiera que haya arrancado más ideas de las que ha podido terminar.

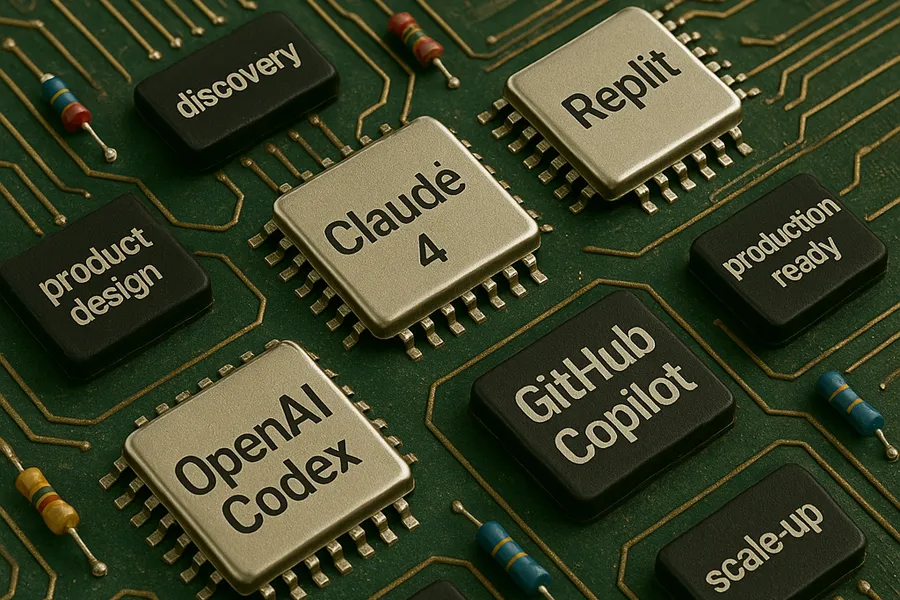

Pero ayer quería ver un componente que me había gustado y quise retomarlo. Esta vez, con una herramienta distinta: la recién salida del horno Claude 4. Más por curiosidad que por expectativas del resultado.

Y lo que pasó fue raro. No porque “funcionara bien”, sino porque lo que hizo fue inesperado. Algo en la forma en que abordó el código, desde la primera respuesta del agente se sintió diferente. No sé si fue por el modelo, el flujo de trabajo que propone, o tal vez por cómo formulé el prompt.. pero miró ese desorden desde otra lógica. No intentó simplemente arreglar el código. Lo leyó como intentando entender la intención detrás del desastre.

Eso me llamó mucho la atención, porque no fue como usar una herramienta que obedece. Fue como tener alguien que te pregunta, sin preguntar, si hay una mejor forma de pensar ese proyecto.

Y ahí me di cuenta de algo importante: que esto no se trata solo de tener acceso a la última IA o de estar al día con todos los lanzamientos, sino también de cómo decidimos usarlas y de armar una estrategia.

No tengo acceso a Codex de OpenAI porque no tengo plan Pro, y honestamente, tampoco tengo capacidad de probar todo al mismo tiempo. GitHub Copilot Agent está en la lista, pero más adelante, cuando llegue el próximo deploy, con su debido tiempo. Porque la realidad es que uno no puede absorberlo todo y seguir pensando con claridad.

Y eso me lleva a una sensación que he visto en muchas conversaciones últimamente: el FOMO técnico. Esa ansiedad de estar quedándose atrás, de no dominar la herramienta del momento, de no integrar cada feature nueva. Y la verdad es que ese miedo también es ruido. Porque no estamos en una competencia de velocidad. Estamos frente a un cambio de paradigma que nos obliga a parar y pensar.

¿Nuestros proyectos están pensados para que una IA pueda colaborar realmente? ¿Estamos diseñando entornos de desarrollo donde un agente pueda entender, interpretar y aportar sin que tengamos que microgestionar cada paso? ¿Le damos a estas herramientas el contexto suficiente, o esperamos que hagan magia en medio de la nada?

Lo que me pasó con Claude 4 no fue que mejoró “mi” código, fue que lo interpretó distinto. Me mostró cosas que estaban ahí, pero no había visto. Y al hacerlo, me empujó a cuestionar no solo cómo programo, sino cómo estructuro mi trabajo, qué dejo explícito y qué asumo que “se entiende solo”.

Y eso se vuelve aún más evidente cuando uno se da cuenta de que estos agentes no arreglan el desorden. Lo reflejan. Si tu repo es un laberinto, lo único que vas a tener es un laberinto asistido. Si tu estructura es ambigua, el output de la IA también lo va a ser.

Por eso creo que necesitamos hablar de estrategia. Pero no en el sentido inflado de la palabra, sino como algo pragmático. Como una manera de decidir con intención:

Qué herramientas usar, y por qué.

Cuándo usarlas, sin que sea por reflejo o costumbre.

Cómo integrarlas sin destruir el flujo que ya teníamos.

Y qué necesita un agente para realmente ayudarnos sin exagerar en el contexto.

AGENTS.md, por ejemplo, me parece brillante. Es como escribirle una bienvenida a la IA, explicándole cómo navegar tu proyecto. Como si fuera un nuevo integrante del equipo. Cursor está haciendo algo similar, y me parece que ese tipo de prácticas son el futuro cercano: no solo escribir código para humanos, sino también para inteligencias que nos acompañan en tiempo real.

Yo no tengo todas las respuestas, de hecho, mientras más exploro estas herramientas, más preguntas me surgen.. pero tal vez ese sea el punto. Que dejemos de buscar verdades absolutas en los rankings de modelos y empecemos a tener mejores conversaciones sobre lo que nosotros ponemos en la mesa.

Porque este momento es raro, estamos dejando atrás la era en la que todo dependía de lo que sabíamos hacer con nuestras manos, y entrando en una donde lo que más importa es cómo diseñamos los sistemas para que nos ayuden. Esto ya lo hemos vivido cuando nuestros equipos crecen y tenemos que delegar, pero esta vez es distinto, y eso es incómodo, pero también es potente.

Ya no se trata de escribir más código ni de lanzar el prototipo más rápido. Se trata de pensar distinto y de pensar más profundo. De pensar en lo que antes ignorábamos porque estábamos demasiado ocupados haciendo lo que hoy hace la IA por nosotros.

¿Tu código es legible para un humano? Bien. ¿Pero lo es también para una IA?

¿Tu entorno de trabajo es colaborativo? Que bueno. ¿Pero está preparado para colaborar con un agente autónomo que no puede “intuir” tus intenciones o conversar contigo mientras toman un café?

¿Estás dejando espacio para que estas herramientas aporten, o estás esperando que te resuelvan sin entenderlas?

Yo sigo sin tener respuestas claras, pero estoy seguro que hay que hacerse mejores preguntas.